O que é o armazenamento em cache?

Na área de computação, um cache é uma camada de armazenamento físico de dados de alta velocidade que guarda um subconjunto de dados, geralmente temporário por natureza, para que futuras solicitações referentes a esses dados sejam atendidas de modo mais rápido do que é possível fazer ao acessar o local de armazenamento principal de dados. O armazenamento em cache permite reutilizar com eficiência dados recuperados ou computados anteriormente.

Como funciona o armazenamento em cache?

Os dados em um cache geralmente são armazenados no hardware de acesso rápido, como uma Random-access memory (RAM – Memória de acesso aleatório), e também podem ser usados em paralelo com um componente de software. O principal objetivo de um cache é aumentar a performance da recuperação de dados ao reduzir a necessidade de acessar a camada subjacente mais lenta de armazenamento.

A substituição de capacidade por velocidade geralmente faz com que um cache armazene um subconjunto de dados de modo temporário, em comparação com bancos de dados, cujos dados são, de modo geral, completos e duráveis.

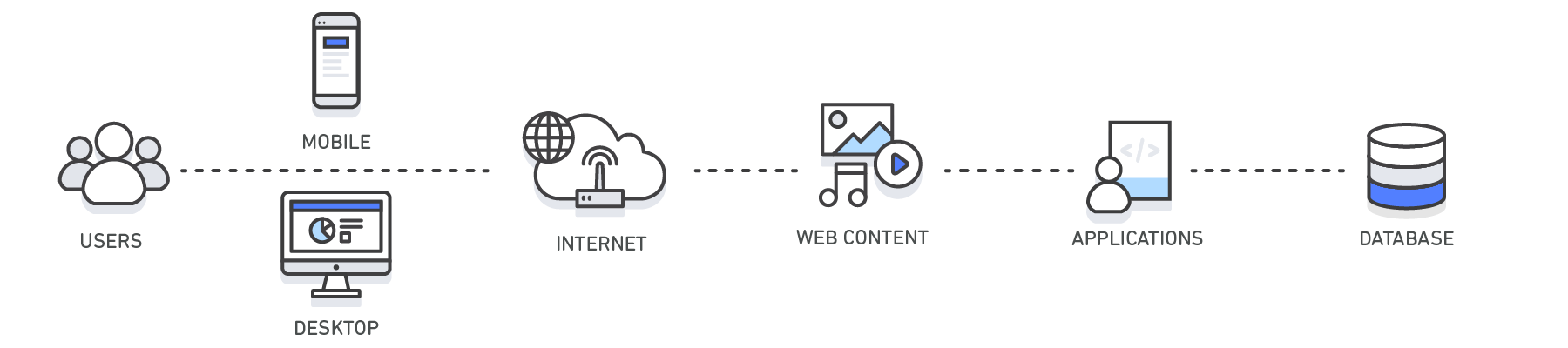

Visão geral do armazenamento em cache

| Camada | Lado do cliente | DNS | Web | Aplicativo | Banco de dados |

| Caso de uso | Acelere a recuperação de conteúdo da web a partir de sites (navegador ou dispositivo) |

Resolução de domínio para IP | Acelere a recuperação de conteúdo da web a partir de servidores web/de aplicativos. Gerencie sessões da web (lado do servidor) | Acelere o desempenho do aplicativo e o acesso aos dados | Reduza a latência associada a solicitações de consulta de banco de dados |

| Tecnologias | Cabeçalhos de cache HTTP, navegadores | Servidores DNS | Cabeçalhos de cache HTTP, CDNs, proxies reversos, aceleradores da web, armazenamentos de chaves/valores | Armazenamentos de dados de chaves/valores, Caches locais | Buffers de banco de dados, armazenamentos de dados de chaves/valores |

| Soluções | Específicas para navegador | Amazon Route 53 | Amazon CloudFront, ElastiCache for Redis, ElastiCache for Memcached, Soluções para parceiros | Estruturas de aplicativos, ElastiCache for Redis, ElastiCache for Memcached, Estruturas de aplicativos | ElastiCache for Redis, ElastiCache for Memcached |

Armazenamento em cache com o Amazon ElastiCache

O Amazon ElastiCache é um serviço web que facilita a implantação, a operação e a escala de armazenamento de dados ou cache na memória na nuvem. O serviço melhora a performance de aplicativos web, o que permite recuperar informações de datastores rápidos e gerenciados na memória, em vez de depender inteiramente de bancos de dados armazenados em disco e sua performance mais lenta. Saiba como você pode implementar uma estratégia de armazenamento em cache eficiente neste whitepaper técnico sobre armazenamento em cache na memória.