RLHF とは何ですか?

人間のフィードバックによる強化学習 (RLHF) は、人間のフィードバックを利用して ML モデルを最適化し、より効率的に自己学習を行う機械学習 (ML) 技術です。強化学習 (RL) 技術では、ソフトウェアが報酬を最大化するような意思決定を行えるようにトレーニングし、その結果をより正確にします。RLHF は報酬機能に人間からのフィードバックを組み込むため、ML モデルは人間の目標、要望、ニーズにより合致したタスクを実行できます。RLHF は、大規模言語モデル (LLM) を含む生成型人工知能 (生成系 AI) アプリケーション全体で使用されます。

RLHF はなぜ重要なのですか?

人工知能 (AI) の用途は、自動運転車から自然言語処理 (NLP)、株式市場予測、小売パーソナライゼーションサービスまで多岐にわたります。どのような用途であっても、AI の目標は、最終的には人間の反応、行動、意思決定を模倣することです。機械学習モデルでは、人間の入力をトレーニングデータとしてエンコードして、複雑なタスクを完了したときに AI が人間をより忠実に模倣できるようにする必要があります。

RLHF は、教師あり学習や教師なし学習などの他の手法と並んで、AI システムをより人間らしく見えるように訓練するために使用される特定の手法です。まず、モデルの応答を人間の応答と比較します。次に、人間がマシンからのさまざまな応答の品質を評価し、どの応答がより人間らしく聞こえるかを採点します。スコアは、親しみやすさ、適切な文脈化、気分など、本質的に人間らしい資質に基づいて決めることができます。

RLHF は自然言語理解において優れていますが、他の生成系 AI アプリケーションでも使用されています。

AI のパフォーマンスを強化します

RLHF は ML モデルをより正確にします。事前に生成されたヒューマンデータでモデルをトレーニングすることはできますが、ヒューマンフィードバックループを追加すると、初期状態と比較してモデルのパフォーマンスが大幅に改善されます。

たとえば、テキストをある言語から別の言語に翻訳する場合、モデルは技術的には正しいが、読者には不自然に聞こえるテキストを生成する場合があります。プロの翻訳者は、まず機械で生成された翻訳にスコアを付けて翻訳を行い、次に機械で生成された一連の翻訳の品質を評価します。モデルにさらにトレーニングを加えることで、自然な響きの翻訳がしやすくなります。

複雑なトレーニングパラメータを導入

生成系 AI では、特定のパラメータについてモデルを正確にトレーニングすることが難しい場合があります。たとえば、楽曲の雰囲気をどう定義しますか? 特定のムードを示すキーやテンポなどの技術的パラメータがあるかもしれませんが、楽曲の精神は、一連の技術的要素よりも主観的で、あまり明確ではありません。その代わり、作曲家がムーディーな作品を作成するように人間によるガイダンスを提供し、機械で生成された楽曲にそのムーディーのレベルに応じてラベルを付けることができます。これにより、マシンはこれらのパラメータをより迅速に学習できます。

ユーザー満足度の向上

ML モデルは正確ですが、人間のようには見えない場合があります。RL は、人間のユーザーにとって最良かつ最も魅力的な応答が得られるようにモデルを導くために必要です。

例えば、チャットボットに外の天気を尋ねると、「摂氏 30 度で雲があり湿度が高いです」と答えたり、「今の気温は 30 度前後です」と答えたりします。「外は曇りで湿度が高いので、空気が濃く見えるかもしれません!」どちらの回答も同じことを言っていますが、2 つ目の回答の方が自然で、コンテキストも豊富です。

人間のユーザーがどのモデル応答を好むかを評価すると、RLHF を使用して人間のフィードバックを収集し、モデルを改善して実際のユーザーに最適な結果を得ることができます。

RLHF はどのように機能しますか?

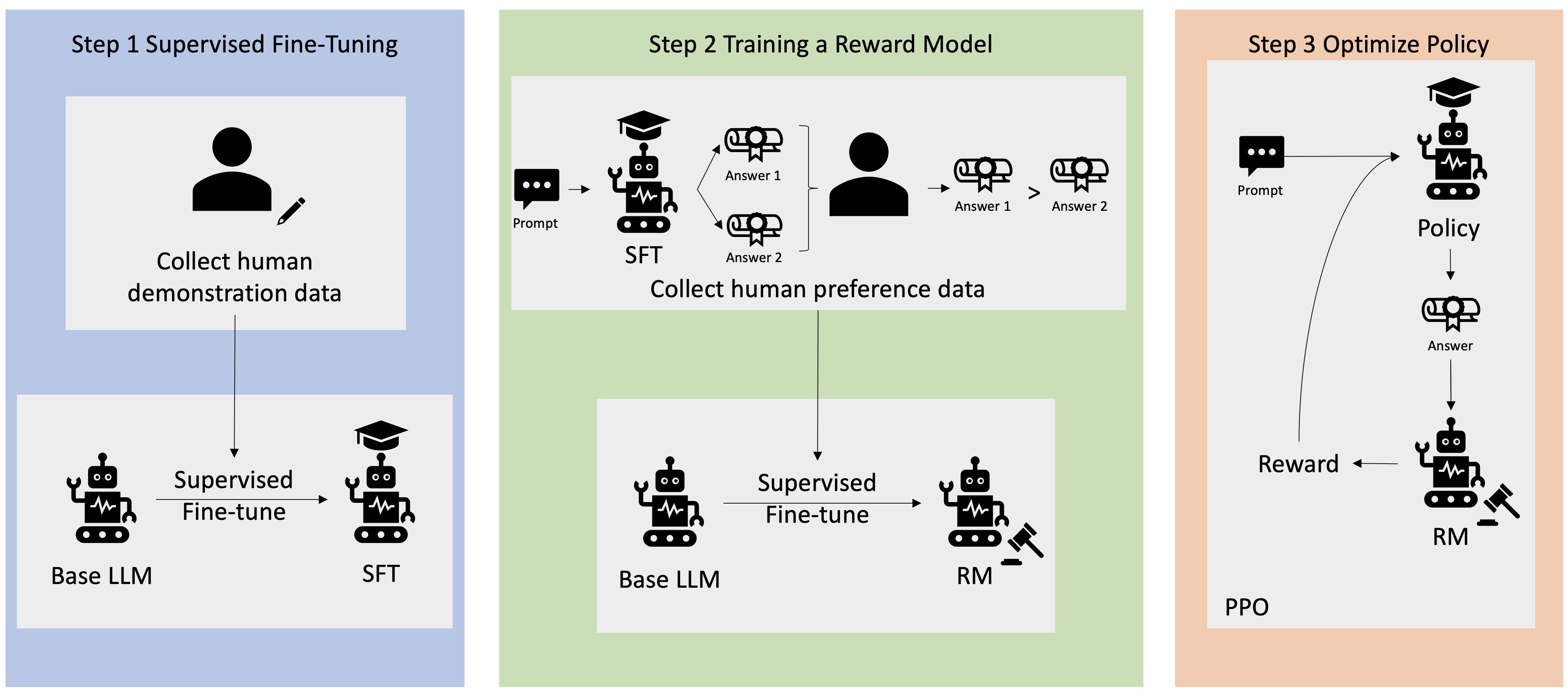

RLHF は、モデルが準備完了と見なされる前に4段階で実行されます。ここでは、RLHF を使用して改良した言語モデル (社内のナレッジベースチャットボット) の例を使用します。

学習プロセスの概要のみを示します。RLHF のモデルのトレーニングとそのポリシーの改良には、数学的にかなり複雑です。ただし、複雑なプロセスは RLHF で明確に定義されており、多くの場合、独自の入力のみを必要とするアルゴリズムがあらかじめ組み込まれています。

データ収集

言語モデルを使用して ML タスクを実行する前に、トレーニングデータ用に人間が生成する一連のプロンプトと応答が作成されます。このセットは、モデルのトレーニングプロセスの後半で使用されます。

たとえば、次のようなプロンプトが表示されます。

- 「ボストンの HR 部の所在地はどこですか?」

- 「ソーシャルメディアへの投稿の承認プロセスはどのようなものですか?」

- 「第1四半期のレポートでは、以前の四半期レポートと比較して、売上についてどのようなことが示されていますか?」

その後、社内のナレッジワーカーは、これらの質問に正確で自然な回答で答えます。

言語モデルの教師あり微調整

市販の事前トレーニング済みモデルを RLHF の基本モデルとして使用できます。検索拡張生成 (RAG) などの手法を使用して、モデルを社内のナレッジベースに合わせて微調整できます。モデルを微調整したら、あらかじめ決められたプロンプトに対する応答を、前のステップで収集した人間の応答と比較します。数学的手法により、両者の類似度を計算できます。

たとえば、機械で生成された応答には、0 から 1 までのスコアを割り当てることができます。1 が最も正確で、0 が最も正確でありません。これらのスコアにより、モデルには人間の応答に近いスコアが得られるように設計されたポリシーが組み込まれています。このポリシーは、モデルに関する今後のすべての意思決定の基礎となります。

個別の報酬モデルの構築

RLHF の中核は、人間のフィードバックに基づいて別の AI 報酬モデルをトレーニングし、このモデルを報酬関数として使用して RL を通じてポリシーを最適化することです。同じプロンプトに応答するモデルからの複数の応答のセットが与えられると、人間は各応答の品質に関して自分の好みを示すことができます。これらの回答評価設定を使用して報酬モデルを構築します。このモデルでは、特定の迅速な応答に対して人間がどれだけ高いスコアを出すかを自動的に推定できます。

報酬型モデルによる言語モデルの最適化

次に、言語モデルは報酬モデルを使用して、プロンプトに応答する前にポリシーを自動的に調整します。報酬モデルを使用して、言語モデルは一連の応答を内部で評価し、最大の報酬が得られる可能性が最も高い応答を選択します。つまり、より最適化された方法で人間の好みを満たすということです。

次の図は、RLHF 学習プロセスの概要を示しています。

RLHF は生成系 AI の分野でどのように使用されていますか?

RLHF は、LLM が真実で無害で役立つコンテンツを作成できるようにするための業界標準技術として認められています。しかし、人間のコミュニケーションは主観的かつ創造的なプロセスであり、LLM のアウトプットの有用性は人間の価値観や好みに大きく影響されます。各モデルのトレーニング方法は少しずつ異なり、使用するヒューマンレスポンダーも異なるため、競合する LLM 間でもアウトプットは異なります。各モデルが人間の価値観をどの程度含んでいるかは、完全に作成者次第です。

RLHF の応用は、LLM の枠を超えて、他のタイプの生成系 AI にも広がっています。次に例を示します。

- RLHF は AI 画像生成に使用できます。たとえば、アートワークのリアリズム、専門性、雰囲気の測定などに使用できます。

- 音楽生成において、RLHF は特定のムードやサウンドトラックをアクティビティに合わせる音楽制作を支援します。

- RLHF を音声アシスタントに使用すると、より親しみやすく、好奇心旺盛で、信頼できる音声に誘導できます。

AWS は RLHF の要件にどのように役立ちますか?

Amazon SageMaker Ground Truth には、人間のフィードバックを ML ライフサイクル全体に組み込んで、モデルの精度と関連性を向上させるための、最も包括的なヒューマンインザループ機能が備わっています。データ生成や注釈付けから、報酬モデルの生成、モデルのレビュー、セルフサービスまたは AWS マネージドサービスを通じたカスタマイズまで、さまざまなヒューマンインザループタスクを完了できます。

SageMaker グラウンドトゥルースには、RLHF 機能用のデータアノテーターが含まれています。RL 結果に対する応答に対してランク付け、分類、またはその両方を行うことで、モデルが生成した出力に直接フィードバックやガイダンスを与えることができます。比較データやランキングデータと呼ばれるデータは、実質的には報酬モデルまたは報酬関数であり、モデルのトレーニングに使用されます。比較データやランキングデータを使用して、既存のモデルをユースケースに合わせてカスタマイズしたり、ゼロから構築したモデルを微調整したりできます。

今すぐアカウントを作成して、AWS で RLHF 技術を使い始めましょう。