Was ist SageMaker Modelltraining?

Amazon-SageMaker-Modelltraining reduziert den Zeit- und Kostenaufwand für das Training und die Optimierung von Machine-Learning-Modellen (ML) in großem Maßstab, ohne dass die Infrastruktur verwaltet werden muss. Sie können die derzeit leistungsstärkste ML-Recheninfrastruktur nutzen, und Amazon SageMaker AI kann die Infrastruktur automatisch nach oben oder unten skalieren, von einem bis zu Tausenden von GPUs. Um Deep-Learning-Modelle schneller zu trainieren, hilft Ihnen SageMaker AI bei der Auswahl und Verfeinerung von Datensätzen in Echtzeit. Die verteilten Trainingsbibliotheken von SageMaker können große Modelle und Trainingsdatensätze automatisch auf mehrere AWS-GPU-Instances aufteilen. Alternativ können Sie Bibliotheken von Drittanbietern wie DeepSpeed, Horovod oder Megatron verwenden. Dank der automatischen Überwachung und Reparatur von Trainingsclustern lassen sich Basismodelle (FMs) über Wochen und Monate ununterbrochen trainieren.

Vorteile einer kostengünstigen Schulung

Modelle jeder Größenordnung trainieren

Vollständig verwaltete Trainingsaufträge

SageMaker-Trainingsaufträge bieten ein vollständig verwaltetes Benutzerlebnis für umfangreiche verteilte FM-Trainings, sodass die undifferenzierte Schwerstarbeit rund um die Infrastrukturverwaltung entfällt. SageMaker-Trainingsaufträge richten automatisch einen ausfallsicheren verteilten Trainingscluster ein, überwachen die Infrastruktur und beheben Fehler automatisch, um ein reibungsloses Trainingserlebnis zu gewährleisten. Sobald das Training abgeschlossen ist, dreht SageMaker den Cluster herunter und Ihnen wird die Netto-Trainingszeit in Rechnung gestellt. Darüber hinaus können Sie bei SageMaker-Schulungsaufträgen flexibel den Instance-Typ auswählen, der am besten zu einem bestimmten Workload passt (etwa ein großes Sprachmodell (LLM) auf einem P5-Cluster vorab trainieren oder ein Open-Source-LLM auf p4d-Instances optimieren), um Ihr Schulungsbudget weiter zu optimieren. Darüber hinaus bietet SageMaker ein konsistentes Benutzererlebnis für ML-Teams mit unterschiedlichem technischem Fachwissen und unterschiedlichen Workload-Typen.

SageMaker HyperPod

Amazon SageMaker HyperPod ist eine speziell entwickelte Infrastruktur zur effizienten Verwaltung von Rechenclustern, um die Entwicklung von Basismodellen (FM) zu skalieren. Es ermöglicht fortgeschrittene Modelltrainingstechniken, Infrastrukturkontrolle, Leistungsoptimierung und verbesserte Modellbeobachtbarkeit. SageMaker HyperPod ist mit verteilten Trainingsbibliotheken von SageMaker vorkonfiguriert, sodass Sie Ihre Modelle und Trainingsdatensätze automatisch auf mehrere AWS-Cluster-Instances aufteilen können, um die Rechen- und Netzwerkinfrastruktur des Clusters effizient zu nutzen. Das Tool ermöglicht eine belastbarere Trainingsumgebung, indem es Hardwarefehler automatisch erkennt, diagnostiziert und behebt, sodass Sie FMs über Monate hinweg ohne Unterbrechung trainieren können. Die Trainingszeit wird dadurch um bis zu 40 % verkürzt.

Leistungsstarkes verteiltes Training

SageMaker AI beschleunigt die Durchführung verteilter Schulungen, indem Ihre Modelle und Trainingsdatensätze automatisch auf AWS-Beschleuniger aufgeteilt werden. Es hilft Ihnen, Ihren Trainingsauftrag für die AWS-Netzwerkinfrastruktur und die Clustertopologie zu optimieren. Außerdem wird das Modell-Checkpointing über die Rezepte optimiert, indem die Häufigkeit des Speicherns von Checkpoints optimiert wird, wodurch ein minimaler Overhead während des Trainings gewährleistet wird. Mit den Rezepten profitieren Datenwissenschaftler und Entwickler aller Qualifikationsstufen von modernster Leistung, während sie schnell mit dem Training beginnen und öffentlich verfügbare Modelle der generativen KI optimieren können, darunter Llama 3.1 405B, Mixtral 8x22B und Mistral 7B. Die Rezepte enthalten einen von AWS getesteten Trainings-Stack, wodurch wochenlange mühsame Tests verschiedener Modellkonfigurationen entfallen. Sie können mit einer einzeiligen Rezeptänderung zwischen GPU-basierten und AWS Trainium-basierten Instances wechseln und automatisierte Modell-Checkpoints für eine verbesserte Trainingsresilienz aktivieren. Darüber hinaus können Sie Workloads in der Produktion mit dem SageMaker-Trainings-Feature Ihrer Wahl ausführen.

Integrierte Tools für Interaktivität und Überwachung

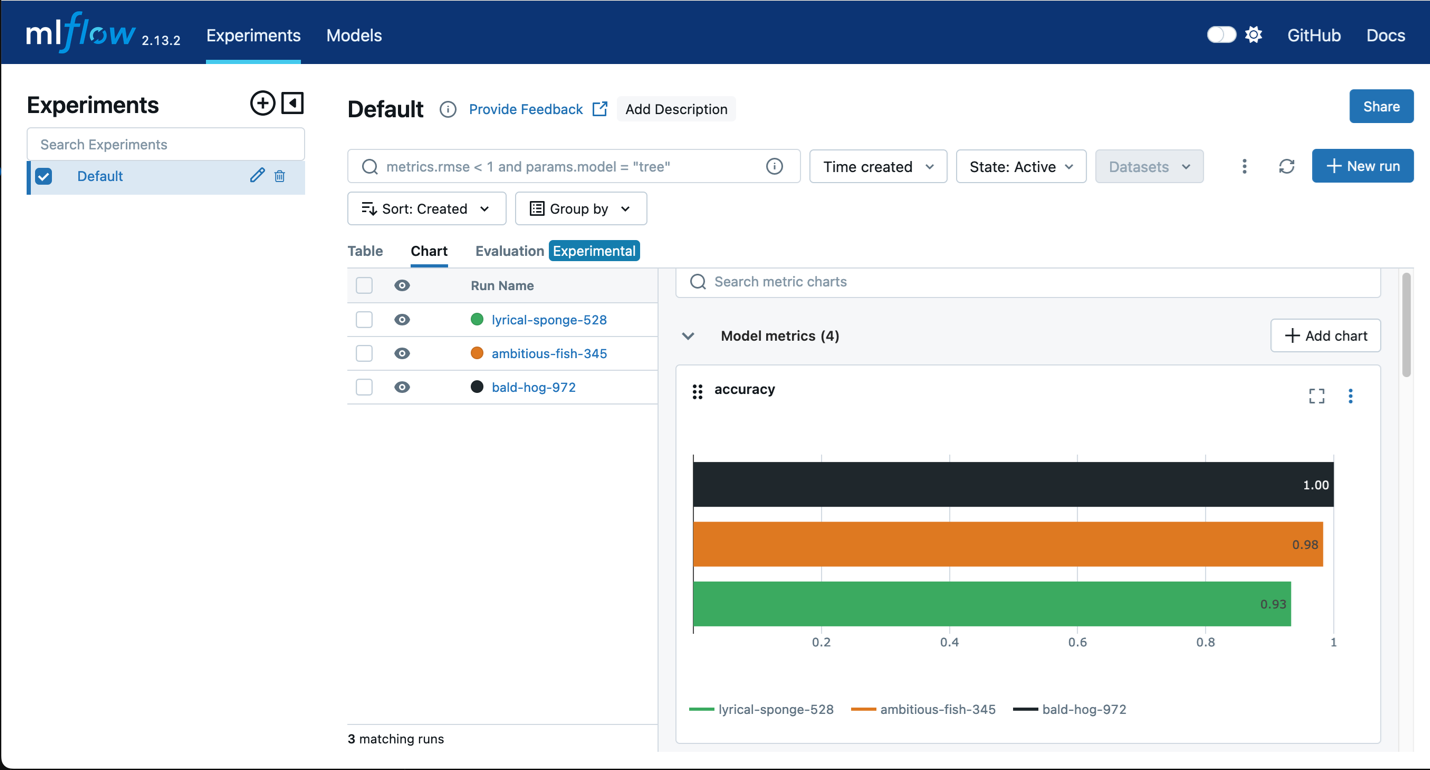

Amazon SageMaker mit MLflow

Verwenden Sie MLflow mit SageMaker Training, um Eingabeparameter, Konfigurationen und Ergebnisse zu erfassen. So können Sie schnell die leistungsfähigsten Modelle für Ihren Anwendungsfall identifizieren. Die MLflow-Benutzeroberfläche ermöglicht es Ihnen, Modelltrainingsversuche zu analysieren und mühelos Kandidatenmodelle für die Produktion in einem schnellen Schritt zu registrieren.

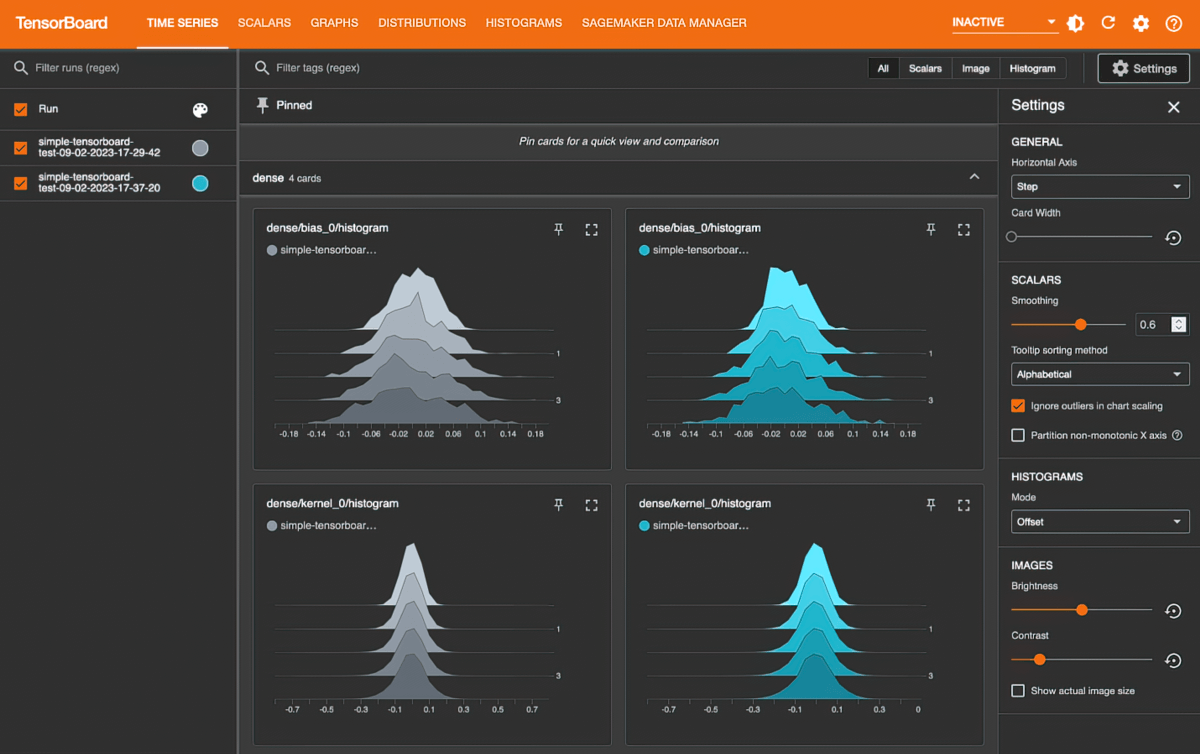

Amazon SageMaker mit TensorBoard

Amazon SageMaker mit TensorBoard hilft Ihnen, Entwicklungszeit zu sparen, indem Sie die Modellarchitektur visualisieren, um Konvergenzprobleme zu identifizieren und zu beheben, wie z.B. nicht konvergierende Validierungsverluste oder verschwindende Gradienten.