Was ist Caching?

Ein Cache ist in der Informationstechnologie eine Hochgeschwindigkeitsspeicherebene, auf der eine Datenteilmenge meist temporär gespeichert wird und über die diese Daten bei zukünftigen Anfragen schneller bereitgestellt werden können als über den primären Speicherort dieser Daten. Über Caching können bereits abgerufene oder berechnete Daten effizient wiederverwendet werden.

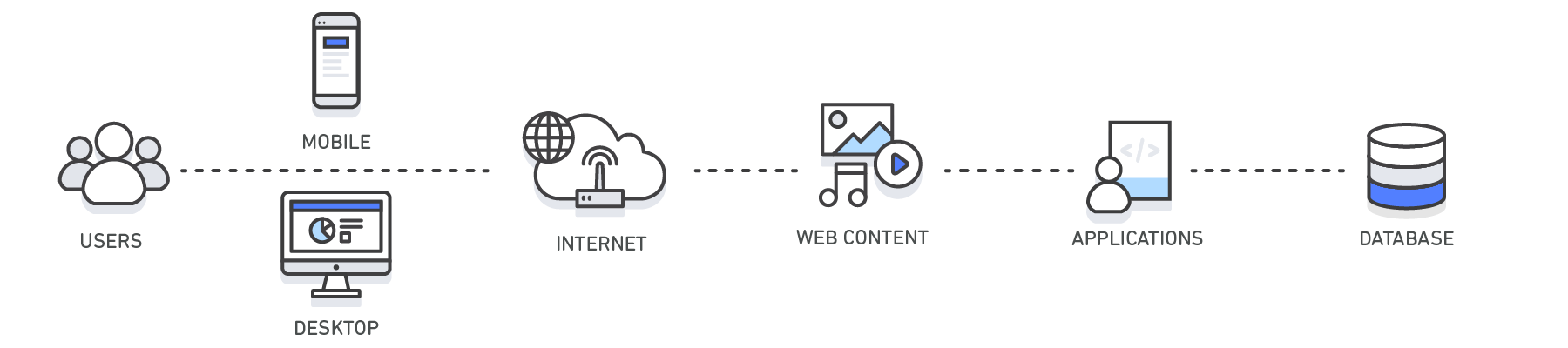

Wie funktioniert Caching?

Die Daten in einem Cache werden im Allgemeinen auf Hardware mit schnellem Zugriff gespeichert, beispielsweise im RAM (Random Access Memory), gelegentlich auch in Verbindung mit einer Softwarekomponente. Zweck eines Cache sind schnellere Datenabrufzeiten durch Vermeidung eines Zugriffs auf die zugrunde liegende langsamere Speicherebene.

Der Geschwindigkeit eines Cache steht als Nachteil seine geringere Kapazität gegenüber. In einem Cache wird in der Regel nur eine Teilmenge der Daten, und dies auch nur vorübergehend, gespeichert, während die Daten in einer Datenbank in der Regel vollständig und persistent sind.

Caching – Übersicht

| Ebene | Client-Seite | DNS | Web | App | Datenbank |

| Anwendungsfall | Beschleunigung des Abrufs von Web-Inhalten von Websites (Browser oder Gerät) |

Domain-zu-IP-Auflösung | Beschleunigung des Abrufs von Webinhalten von Web-/App-Servern Verwalten von Web-Sitzungen (serverseitig) | Beschleunigen der Anwendungsleistung und des Datenzugriffs | Verringerung der Latenz bei Datenbankabfragen |

| Technologien | HTTP-Cache-Header, Browser | DNS-Server | HTTP-Cache-Header, CDNs, Reverse-Proxys, Web-Beschleuniger, Schlüssel/Wert-Speicher | Schlüssel/Wert-Datenspeicher, lokale Caches | Datenbankpuffer, Schlüssel/Wert-Datenspeicher |

| Lösungen | Browserspezifisch | Amazon Route 53 | Amazon CloudFront, ElastiCache for Redis, ElastiCache for Memcached, Partnerlösungen | Anwendungsframeworks, ElastiCache for Redis, ElastiCache for Memcached, Partnerlösungen | ElastiCache für Redis, ElastiCache für Memcached |

Caching mit Amazon ElastiCache

Amazon ElastiCache ist ein Webservice, mit dem ein In-Memory-Datenspeicher oder -Cache auf einfache Weise in der Cloud bereitgestellt, betrieben und skaliert werden kann. Der Service verbessert die Leistung von Webanwendungen, da Sie die Möglichkeit haben, Informationen aus schnellen, verwalteten In-Memory-Datenspeichern abzurufen, anstatt sich vollständig auf langsamere datenträgerbasierte Datenbanken verlassen zu müssen. Erfahren Sie in diesem technischen Whitepaper zu In-Memory-Caching, wie eine effektive Caching-Strategie implementiert werden kann.